🖥️ #81: Chiński model lepszy od GPT-5?

+ sposób na tanie MCP, nauka z AI i data premiery mojego filmu o ChatGPT

Siema!

Analizujemy dziś nowy, chiński model Kimi K2, o którym od kilku dni bardzo głośno w bańce AI. Sprawdzimy, czy faktycznie mainstreamowe modele typu GPT-5 mają się czego obawiać.

Do tego spory update do mojego filmu o ChatGPT i w końcu data premiery! Jaram się, bo w końcu zwieńczy się te kilka miesięcy pracy.

No i na koniec, na dole czekają na Ciebie 4 ciekawe linki.

Enjoy!

Film i kanał na YouTube

Premiera mojego filmu ChatGPT od środka: jak naprawdę działa LLM? zbliża się wielkimi krokami! W poprzednim tygodniu udało mi się dopiąć miniaturkę, film już śmiga na niepublicznym i czeka na wydanie.

Premiera w niedzielę 16 listopada o 18:00 na moim kanale na YouTube!

Subskrybuj, żeby nie przegapić i kliknij dzwoneczek, żeby dostać powiadomienie:

Do tego filmu przygotwałem jeszcze coś extra, co może Ci się spodobać 👀

Będzie to ebook z pełnym opracowaniem, niektóre wątki są lekko rozszerzone. Idealny, żeby zrobić sobie powtórkę po zobaczeniu filmu - pisałem go właśnie z myślą o tym. Polecam jednak najpierw zobaczyć cały film, wszystkie wykresy i techniczne wątki są tam dużo lepiej przedstawione.

Najważniejsze - będzie całkowicie za darmo. Podrzucę Ci go w poniedziałkowym wydaniu newslettera, dzień po premierze filmu.

A w międzyczasie obczaj kolejny krótki fragment z jednego rozdziału. Tym razem troszkę więcej filmu niż suchych wykreśów:

Kimi K2 Thinking - chiński pogromca GPT-5?

Chiny doganiają, znowu. Czy właśnie przeżywamy DeepSeek moment 2.0?

Firma Moonshot AI wypuściła open source’owy model (razem z parametrami), który w wielu benchmarkach (np. Humanity’s Last Exam, BrowseComp) pokonuje tych najlepszych, włącznie z modelem od OpenAI. W niektórych jest nieco gorszy (np. tych związanych z kodowaniem), ale nie odstaje znacząco. Kosztuje przy tym kilka razy mniej.

Kimi mocno bazuje agencyjności, wykorzystywaniu narzędzi. Może wykonać nawet do 200-300 kolejnych wywołań narzędzi bez ingerencji człowieka.

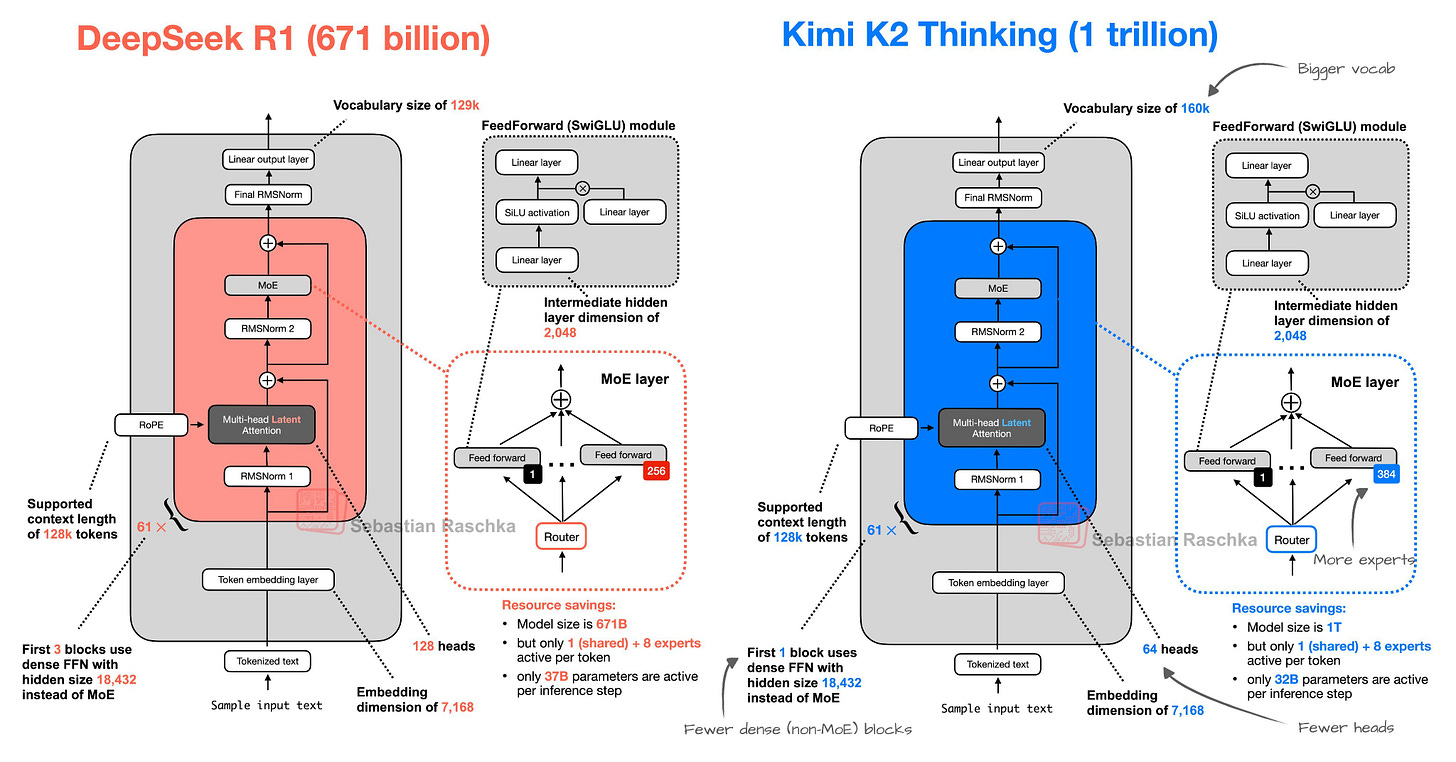

Opera się on na architekturze DeepSeek R1, ze zmienioną liczbą tzw. ekspertów (od architektury Mixture-of-Experts), liczbą “głów” (attention), większym kontekstem (256K)…

W co akurat nie dowierzam, to informacja o koszcie wytworzenia modelu. Twrócy podają, że trening koztował tylko 4.6 miliona dolarów.

Mam nadzieję, że podobnie jak to było kiedyś przy DeepSeek, ta premiera popchnie do przodu rozwój LLM’ów, da pstryczka tym największym graczom i zachęci do większej otwartości i niższych cen. Same plusy dla nas, końcowych użytkowników :)

Wypróbować go można na kimi.com, a nawet przez Claude Code, instrukcję znajdziesz na stronie producenta.

Ciekawe linki

Sam Altman: AI progress and recommendations

Nowy artykuł od OpenAI, w którym dowiadujemy się np. że koszt „jednostki inteligencji” spada ~40× rocznie, AI przechodzi od sekundowych do godzinowych zadań, wkrótce dni/tygodni. Trochę też o perspektywie nauki i dropnych wynalazkach już w 2026 roku.

Książka od HuggingFace o budowaniu LLM’ów (free)

HF to taki GitHub dla AI. Twórcy serwisu przygotowali playbooka, w którym opisują trening ich modelu SmolLM3. Chociaż pewnie nie będziesz budował swojego modelu, warto rzucić okiem, dużo ciekawych rzeczy!

MCP i code execution: mniej tokenów, szybsi agenci

Standard w budowaniu narzędzi dla agentów, który nie jest pozbawiony wad. Zapychanie kontekstu, czy wysokie koszta z tym związane, to jedne z nich. Anthropic dzieli się nowym podejściem, które ma rozwiązać część problemów i jest to naprawdę super ciekawe.

Sztuczna inteligencja jest świeta w roli nauczyciela/kompana do nauki. Warto jednak najpierw nauczyć się, jak efektywnie wykorzystać ją w tym celu. Kamil dzieli się fajnych materiałem z 10 trickami do nauki z AI.

Już uciekasz?

Jeśli Ci się podobało, kliknij 🧡 poniżej, to nic nie kosztuje! Doceniasz w ten sposób moją pracę i motywujesz do dalszych działań :)

Do następnego,

Olaf